La gestion des postes de travail a toujours été pour les grandes entreprises un véritable casse-tête, et pour les petites entreprises un simple cauchemar. Or avec les progrès liés à la virtualisation hardware, à la virtualisation des applications, aux technologies de déport d’interfaces (RDS – Remote Desktop Services) de nombreuses offres dites de VDI (Virtual Desktop Infrastructure) sont apparues, proposant de ré-centraliser l’exécution de l’environnement de travail des utilisateurs sur les serveurs de l’entreprise. La démarche comme nous allons le voir n’est pas inintéressante, mais les attentes de réduction de coût d’exploitation se sont assez rapidement heurtées aux investissements pharaoniques d’infrastructure à mettre en œuvre (serveurs, réseau, stockage).

La gestion des postes de travail a toujours été pour les grandes entreprises un véritable casse-tête, et pour les petites entreprises un simple cauchemar. Or avec les progrès liés à la virtualisation hardware, à la virtualisation des applications, aux technologies de déport d’interfaces (RDS – Remote Desktop Services) de nombreuses offres dites de VDI (Virtual Desktop Infrastructure) sont apparues, proposant de ré-centraliser l’exécution de l’environnement de travail des utilisateurs sur les serveurs de l’entreprise. La démarche comme nous allons le voir n’est pas inintéressante, mais les attentes de réduction de coût d’exploitation se sont assez rapidement heurtées aux investissements pharaoniques d’infrastructure à mettre en œuvre (serveurs, réseau, stockage).

Mais le VDI n’a, il faut le constater, pas répondu aux attentes, en tout cas comme solution globale de remplacement d’un poste physique sur lequel est installé un système d ‘exploitation correctement géré et sécurisé.

Avec cependant certains scénarios d’usages qui pouvaient justifier les investissements d’infrastructure tels que la complexité d’une intervention physique sur certains postes de travail à des fins de support, la possibilité de « réinitialisation » de postes en libre service, la mise a disposition d’un environnement de travail sécurisé sur des ordinateurs non gérés, etc.

Mais deux éléments pourraient changer la donne et redonner au VDI un second souffle : Le besoin pour les entreprises de proposer des environnements de travail correctement gérés sur des matériels ingérables (le BYOD, la prise en compte des Mac, et les tablettes), et l’arrivée récente de deux acteurs majeurs (VMware et Amazon) sur un marché jusqu’alors très morcelé qu’est le Desktop-as-a-Service (DaaS), consistant à fournir sous forme d’un service Cloud les solutions VDI.

D’où cet article…

Avant de parler du DaaS, quelques rappels sur le VDI

Tout d’abord il est important de préciser que le concept de VDI englobe de nombreuses acceptations qui vont de la simple machine virtuelle téléchargée sur un poste de travail jusqu’à la mise à disposition d’un environnement de travail complet et reconstruit lors de la connexion vers le périphérique de l’utilisateur, le tout par déport d’interface (nous avons eu l’occasion de détailler ces différentes approches lors du Briefing Calipia du printemps 2013).

Cette dernière approche (VM – Machine Virtuelle – sur des serveurs) est celle qui est potentiellement la plus intéressante (et qui est proposée dans les offres DaaS). Elle peut être mise en œuvre de trois façons

- Stateless : L’utilisateur se voit attribuer une nouvelle VM à chaque connexion.

- Peu de VMs à maintenir : stockage moindre / administration simplifiée.

- L’utilisateur à un environnement « propre ».

- Mais pas de personnalisation par l’utilisateur ou d’installation d’applications non déjà présentes.

- Stateful : Chaque utilisateur a sa propre VM dont les modifications (paramétrage, installation d’applications, etc.) sont sauvegardées.

- Impact fort sur l’infrastructure de stockage.

- Peu d’économies d’administration (gestion des VMs comme des PC physiques).

- Layered : Utilisation d’images (OS/applications) de type Stateless et d’une couche de personnalisation (profile) pour assurer la persistance des modifications effectuées par l’utilisateur lors de la reconnexion. Le bureau de travail est dynamiquement reconstruit lors de la connexion (mais à partir de briques – OS et applications de type Stateless et contrôlées par l’IT). C’est l’approche la plus sophistiquée et récente, avec peu de déploiements à grande échelle.

- Souplesse pour l’utilisateur (installation, paramétrage).

- Remise à zéro simple du poste virtuel en cas de problèmes.

- Gestion du changement simple puisque sur des images OS et applications de type Stateless et donc standardisées.

- Bon compromis pour le stockage puisque de nombreux éléments sont partagés.

Sur ce marché les acteurs principaux sont par ordre d’importance VMware (View), Citrix (Xen Desktop), Dell (Quest vWorkspace), et Microsoft (Windows Server).

Pourquoi n’y a t’il que très peu de déploiement d’architectures VDI à grande échelle ?

Tout simplement parce que les coûts d’infrastructure sont très importants. Et que cette infrastructure doit être redondante pour assurer une disponibilité de service qui est dans ce type de scénario assez critique puisqu’on parle de la possibilité pour un employé d’utiliser son ordinateur.

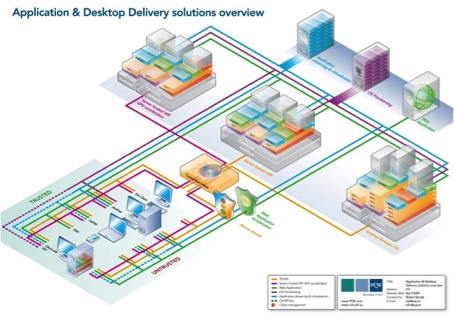

Il faut des serveurs pour la virtualisation, des serveurs pour le déport d’interface, des baies de stockage SAN, une infrastructure réseau repensée, avec de l’accélération Web et de la sécurisation d’accès, etc. Pour résumer, voilà un aperçut d’une infrastructure VDI idéale:

Quant au dimensionnement de cette infrastructure serveur, quelques points ont considérablement freiné les ardeurs des entreprises :

- CPU : Il n’est pas raisonnable d’aller au delà de 8 VMs (donc postes clients) par cœur pour les serveurs de virtualisation. Il serait raisonnable de ne pas dépasser 4 VMs par cœur, et il serait souhaitable de reproduire sur les serveurs les même conditions d’exécution que sur les postes (2 cœurs sur le poste = 2 cœurs sur le serveur), afin de ne pas introduire de frustration des utilisateurs.

- Mémoire : Il est nécessaire de prévoir sur les serveurs de virtualisation une capacité RAM correspondant à la somme des capacités disponibles sur les postes.

- Entrées / Sorties (E/S) Disque : Ce critère est probablement le plus important puisque l’exécution simultanée de plusieurs machine virtuelles sur un serveur peut rapidement générer un nombre important d’E/S. Il faut compter par exemple près de 4 000 E/S par seconde pour 64 VMs sur un serveur, ce qui implique l’utilisation d’un SAN et donc un investissement supplémentaire.

- Réseau : La centralisation de l’environnement de travail sur les serveurs implique une parfaite disponibilité des infrastructures réseau (dans le cas d’un usage intra-entreprise), mais aussi un accès internet fiable et la mise œuvre de technologies d’optimisation/compression du trafic pour les utilisateurs itinérants.

De plus cette architecture n’apporte aucune solution à l’aspect gestion des postes, sauf à opter pour une approche Stateless (remise à zéro à chaque connexion) qui de plus n’empêchera pas un utilisateur, lorsque sa session est active, d’enfreindre allègrement toutes les règles de sécurité que l’entreprise aura définies.

Pire, dans une approche Stateful il sera nécessaire de gérer non pas des postes physiquesà mais des machines virtuelles qui peuvent être inactives et donc plus difficiles à mettre à niveau ou a configurer.

Et il me paraît enfin important de rappeler qu’un des principaux centres de coût lié au poste de travail, les licences logicielles, n’est en aucun cas réduit par une approche VDI, sauf à abandonner Windows et basculer sous Linux pour les environnements proposés aux utilisateurs. En effet l’utilisation de Windows dans un environnement virtualisé nécessite une licence VDA (Virtual Desktop Access), en plus évidemment de la licence physique associée au PC si celui ci est un PC sous Windows, et des licences nécessaires pour les applications qui seront disponibles pour les utilisateurs…

Le DaaS résout-il ces problèmes ?

Par rapport à une approche VDI interne, dont le plus grand problème est l’investissement lié à l’infrastructure, l’approche Desktop-as-a-Service apporte incontestablement une facilité pour des directions informatiques en déplaçant leurs investissements (CAPEX) vers des frais de fonctionnement (OPEX) correspondant aux abonnements mensuels liés à la mise à disposition des environnement de travail des utilisateurs. Comme en fait pour toute externalisation de services internes vers le Cloud (ou vers des prestataires d’hébergement / infogérance avant que le terme de Cloud Computing soit aussi populaire). Mais cet argument n’est valable que si l’on prend en compte une augmentation spectaculaire des budgets de fonctionnement, qu’il va falloir bien entendu justifier ! Ce qui n’est pas forcément simple.

Quid de la mutualisation (OS = client de messagerie à votre avis) ?

Un des autres avantages de l’approche Cloud Computing est la mutualisation des infrastructures permettant de répondre de façon rapide et moins coûteuse à une augmentation ou diminution des besoins de traitement (CPU/réseau/stockage/etc.).

Cette mutualisation est intéressante pour des scénarios dans lesquels l’usage du service proposé étant aléatoire, il est possible d’affecter de façon fine les ressources physiques disponibles dans le Datacenter afin de répondre aux demandes. C’est typiquement le cas d’offres de type Software-as-a-Service, qui par exemple pour la messagerie le CRM ou la messagerie instantanée, peuvent tabler sur une utilisation variable des ressources lors d’une journée par exemple. Variabilité permettant par la ré-allocation de ressources matérielles de proposer des solutions très compétitives.

Mais en ce qui concerne le DaaS, même si la mutualisation est mise en avant par les différents fournisseurs, il est peu réaliste d’imaginer que cette optimisation pourra être mise en œuvre. Après tout j’allume mon ordinateur le matin, et souvent je ne l’éteins pas le soir … il faut donc que les engagements de ressources des prestataires correspondent à des cœurs de processeurs, à des disques durs, à une bande passante et à des quantités de RAM physiquement disponibles à tout moment.

Ce qui en soit n’est pas un problème. Mais qui n’est pas non plus la garantie d’une substantielle économie. Ce qui explique les coûts importants des offres DaaS actuellement disponibles, même si VMware et Amazon ont un peu bousculé les choses avec des prix d’appel assez séduisants.

Quid de l’expérience utilisateur (Internet partout) ?

Un argument intéressant des fournisseurs de solution DaaS (et VDI dans une moindre mesure) est que la connectivité à Internet est maintenant possible partout. Ou presque.

Soit, il est vrai qu’il est maintenant facile de se connecter à Internet, soit via des réseaux Wifi, soit via des modems GSM (vos Smartphones).

Mais ce discours me semble assez suspect. En effet il passe sous silence trois éléments qui peuvent avoir leur importance : le coût, la bande passante et le roaming :

- Les connexions Wifi sont rarement gratuites, et lorsqu’elles le sont la bande passante est pitoyable, ce qui ne pose pas de problèmes pour la lecture de mails mais pourrait assez rapidement agacer un utilisateur si chaque clic de souris implique plusieurs secondes d’attente.

- Quant à l’utilisation du Smartphone comme modem, réponse au manque de couverture Wifi, outre les débits très variables suivant les opérateurs et les emplacements géographiques, il me semble important de rappeler que :

- Les abonnements datas sont généralement limités en Giga-octets transmis (avant de passer dans un mode dégradé qui n’est guère compatible avec l’exécution d’un OS et de ses applications). Sauf évidemment à souscrire à des abonnements spéciaux et être prêts à payer mensuellement une centaine d’euros pour que vos utilisateurs puissent accéder à leur bureau de travail.

- Un des scénarios les plus intéressants pour le VDI ou le DaaS est celui de l’utilisateur itinérant. Mais il serait souhaitable que celui-ci reste dans les limites du pays, car si ce n’est pas le cas les factures d’abonnement GSM risquent d’exploser, le roaming étant, et je le déplore, la vache à lait des opérateurs téléphoniques (espoir en vue avec la fin des coûts de roaming en Europe à partir de 2015)..

Attention donc aux coûts cachés. Qui dit centralisation dit connectivité, et cette connectivité se paye malheureusement encore fort cher.

Quid de l’administration ?

Sur ce point il semble que le DaaS n’apporte, si on regarde les offres des différents fournisseurs, que des garanties des services classiques portant sur l’accès à son bureau de travail (disponibilité), des mises à jours des VMs et des services basiques de sécurité (filtrage antivirus, sauvegarde des données).

Si vous pouvez considérer que ces offres sont suffisantes, et pourquoi pas, tout va pour le mieux. Mais sinon il vous faudra prévoir, comme pour une architecture VDI interne de conserver quelques outils et équipes d’administration des environnements virtuels qui seront proposés à vos utilisateurs.

Lisez donc bien les contrats et vos possibilités concernant cette gestion déléguée des postes virtualisés… et ne prévoyez surtout aucune économie concernant l’administration des postes : ils sont certes virtualisés, il sont certes dans les nuages, mais il faut tout de même les gérer. Et c’est vous qui payerez !

Enfin n’oubliez pas de prévoir la gestion et sécurisation des OS hôtes (PC, Mac, tablettes, etc.) qui permettront l’affichage du bureau de travail virtualisé, ou dans un mode off-line permettront l’exécution de la VM correspondante. Parce que sinon vous aurez posé des cautères sur des jambes de bois et ouvert des trous béants en termes de sécurité.

Quid des licences (et des applications) ?

Évidemment le DaaS n’apporte pas vraiment d’avantages concernant ce point, puisque pour les applications proposées, les coûts sont ceux pratiqués par tous les hébergeurs, coûts généralement imposés par les éditeurs de logiciel.

Il peut être de plus intéressant de noter un léger désagrément lié à l’approche DaaS concernant les applications disponibles pour les utilisateurs : Il y a généralement une liste relativement réduite proposée qui intègre au maximum (outre l’OS) les utilitaires Adobe, un navigateur, Winzip, un antivirus et une suite bureautique (Office ou Open Office).

Bien entendu intégrer les quelques applications payantes qui pourraient être proposées n’est possible que via une souscription « plus », « premium », ou autre qualificatif signifiant le passage dans une gamme supérieure de prix…

Ensuite il est possible de laisser les utilisateurs installer leurs propres applications, si vous optez pour les VMs persistantes (stateful). Dans ce cas de figure il sera souhaitable de gérer correctement des applications installées et les paramétrages, ce qui nous ramène au paragraphe précédent concernant l’administration.

Quid des offres et des prix ?

Tout d’abord il faut préciser que la quasi totalité des fournisseurs d’offres DaaS propose des solutions basées sur les technologies de VMware ou Citrix (Cisco, Parallels, Integra, Nexto, etc.). Ce marché relativement confidentiel (à juste titre) revient cependant sur le devant de la scène avec les annonces de deux poids lourds : VMware avec Horizon DaaS, issu du rachat de Desktone (et qui d’ailleurs prend le risque de se mettre en concurrence avec ses partenaires Service Providers) ainsi qu’Amazon (AWS Workspaces), qui proposent des Solutions DaaS avec un prix d’appel de 35 dollars par poste et par mois (mais sans licence VDA puisque l’approche retenue est uniquement basée sur le déport d’interface avec un look Windows 7 pour le bureau de travail).

VMware proposant le mode off-line, et une large couverture d’OS Windows (de XP à 8) on a là un réel différentiateur pour certains scénarios d’usages. Et ce en attendant l’annonce officielle du projet de Microsoft (nom de code Mohoro).

Je vous ferais la grâce d’une comparaison détaillée des prix des différents fournisseurs, sachant tout de même que le prix d’appel, soit 35 dollars de VMware et Amazon ne donne accès à un environnement de travail qui permet péniblement de surfer sur Internet et que des configurations plus réalistes (avec un peu de sécurité et au moins une suite bureautique) sont comme pour les autres fournisseurs historiques entre 70 et 90 euros par mois et par utilisateur ou poste.

En guise de conclusion, beaucoup de bruit pour rien ?

Les architectures VDI et DaaS sont de bonnes solutions pour des scénarios d’usage extrêmement précis, mais il est à mon avis fort peu probable de les voir remplacer un environnement de travail local en l’état actuel des choses. On parle donc ici de choix tactiques plutôt que stratégiques…

Que les acteurs du Cloud ou de la virtualisation s’intéressent à ce changement de paradigme est assez normal, après tout le marché du poste de travail est énorme, et il est possible (voire souhaitable) que les évolutions technologiques nous permettent de nous affranchir un jour des vicissitudes liées au concept archaïque d’un système d’exploitation permettant de faire fonctionner intelligemment des bouts de silicium de cuivre pour nous permettre de surfer sur le site Calipia ;-).

Je ne suis pas cependant sûr de voir cette révolution de mon vivant …

Mon avis est que c’est toujours l’aspect coût qui est toujours essentiel pour sa viabilité car les gens ont generalement tendance a recourir aux services plus abordables

J’aimeJ’aime

C’est effectivement le point que j’évoque assez clairement (coût de l’infrastructure) pour expliquer le succès plus que mitigé du VDI…

J’aimeJ’aime

Je pense que le puissant couple CPU/Ram/OS « local et dans la poche » se fait…. de plus en plus commun > le smartphone en connexion 4G ou 5G. Il n’est pas dans le Cloud.

L’écran aussi > la TV ultra-HD communicante.

Un clavier en +, avec les 3 connectés sans fil…

…. et voilà 1 poste qui gère et échange ses données avec le cloud.

Pourquoi louer CPU/Ram/OS distants, quand on l’a déjà dans la poche et pour pas cher.

J’aimeJ’aime

Vous parlez à juste titre de l’Internet des Objets … mais j’évoquais le poste de travail de l’entreprise. Qui doit juste être administrable, sécurisé et accessoirement pouvoir exécuter quelques applications métier… et si par magie vous pouvez faire tout ça avec votre Smartphone je serais heureux d’être initié à votre secret.

Bien cordialement

Pierre

J’aimeJ’aime